У цій статті приклад оптимального, на мій погляд, коду для файлу robots.txt під WordPress, який ви можете використовувати в своїх сайтах.

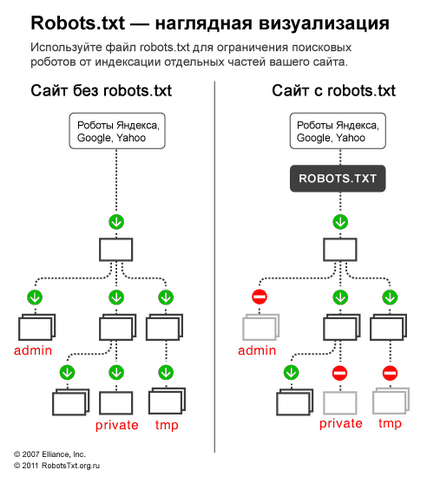

Для початку, згадаємо навіщо потрібен robots.txt - файл robots.txt потрібен виключно для пошукових роботів, щоб «сказати» їм якісь розділи / сторінки сайту відвідувати, а які відвідувати не потрібно. Сторінки, які закриті від відвідування не потраплятимуть в індекс пошукових систем (Yandex, Google і т.д.).

Варіант 1: оптимальний код robots.txt для WordPress

У рядку User-agent: * ми вказуємо, що всі наведені нижче правила будуть працювати для всіх пошукових роботів *. Якщо потрібно, щоб ці правила працювали тільки для одного, конкретного робота, то замість * вказуємо ім'я робота (User-agent: Yandex. User-agent: Googlebot).

- Disallow: / cgi-bin - закриває каталог скриптів на сервері

- Disallow: / feed - закриває RSS фід блогу

- Disallow: / trackback - закриває повідомлення

- Disallow. s = або Disallow: *? s = - закриавет сторінки пошуку

- Disallow: * / page / - закриває всі види пагінацію

З документації Яндекса: «Host - незалежна директива і працює в будь-якому місці файлу (міжсекційна)». Тому її ставимо наверх або в самий кінець файлу, через порожній рядок.

Це важливо: сортування правил перед обробкою

Yandex і Google обробляє директиви Allow і Disallow не по порядку в якому вони вказані, а спочатку сортує їх від короткого правила до довгого, а потім обробляє останнім відповідне правило:

Щоб швидко зрозуміти і застосовувати особливість сортування, запам'ятайте таке правило: «чим довше правило в robots.txt, тим більший пріоритет воно має. Якщо довжина правил однакова, то пріоритет віддається директиві Allow. »

Варіант 2: стандартний robots.txt для WordPress

Не знаю хто як, а я за перший варіант! Тому що він логічніше - не треба повністю дублювати секцію заради того, щоб вказати директиву Host для Яндекса, яка є меж секційної (розуміється роботом в будь-якому місці шаблона, без вказівки до якого роботу вона відноситься). Що стосується нестандартної директиви Allow. то вона працює для Яндекса і Гугла і якщо вона не відкриє папку uploads для інших роботів, які її не розуміють, то в 99% нічого небезпечного це за собою не спричинить. Я поки не помітив що перший robots працює не так як потрібно.

Деякі роботи (НЕ Яндекса і Гугла) - не розуміють більше 2 директив: User-agent: і Disallow:;

3. Sitemap: міжсекційна директива для Яндекса і Google і мабуть для багатьох інших роботів теж, тому її пишемо в кінці через порожній рядок і вона буде працювати для всіх роботів відразу.

На основі цих поправок, коректний код повинен виглядати так:

Дописуємо під себе

Якщо потрібно закрити будь-які входження / news. то пишемо:

Більш детально вивчити директиви robots.txt ви можете на сторінці допомоги Яндекса (але майте на увазі, що не всі правила, які описані там, працюють для Google).

Crawl-delay - таймаут для божевільних роботів

Коли робот Яндекса сканує сайт як божевільний і це створює зайве навантаження на сервер. Робота можна попросити «зменшити обороти».

Для цього потрібно використовувати директиву Crawl-delay. Вона вказує час в секундах, яке робот повинен простоювати (чекати) для сканування кожної наступної сторінки сайту.

Для сумісності з роботами, які погано йдуть стандарту robots.txt, Crawl-delay потрібно вказувати в групі (в секції User-Agent) одразу після Disallow і Allow

Робот Яндекса розуміє дробові значення, наприклад, 0.5 (пів секунди). Це не гарантує, що пошуковий робот буде заходити на ваш сайт кожні півсекунди, але дозволяє прискорити обхід сайту.

Робот Google не розуміє директиву Crawl-delay. Таймаут його роботам можна вказати в панелі вебмастера.

Перевірка robots.txt і документація