Унікальність статті, ключовий момент будь-якого Інтернет проекту. Чому потрібно уникати дублювання контенту. Як вирішити проблему дублювання контенту?

Отже, сьогодні на блозі istokblag.ru в рубриці «Просування сайту» в цій статті ми більш детально розглянемо саме ці питання.

Унікальність статті на сайті є безкоштовним інструментом просування вашого ресурсу в Інтернеті, і ключовим моментом для отримання трафіку на сайт з пошукових систем. У попередній статті «Унікальний контент Гарантія успішного Просування», більш докладно описано, чому важливий унікальний контент, і як це допомагає в просуванні сайту.

Для успішного просування будь-якого ресурсу в Інтернеті, звичайно, потрібно також дотримуватися базові правила оптимізації, і нарощувати кількість посилань. І тут как не странно також потрібно враховувати унікальність статті. Для цього після розміщення унікальних статей, потрібно отримати якісні зворотні посилання з унікальним описом (анкором), для того щоб підняти статтю в ТОП пошукової видачі.

Давайте подивимося на послідовність подій, як відбувається ранжирування вашого сайту в будь-якій пошуковій системі. Перш за все, ви повинні зрозуміти, що будь-яка пошукова система спочатку шукає, і видає на перші позиції відповідний, оригінальний і унікальний матеріал, який більше ніде не можна знайти в Інтернеті.

Іноді дублювання контенту може працювати, але це тільки тоді, коли пошуковим системам більше нічого показувати. Але поверти мені, що це відбувається вкрай рідко.

Пошукові системи будь-яку ціну намагаються уникати надання користувачам матеріалу однакового за змістом. Єдиний спосіб зробити це. Це вибрати для відображення лише один унікальний екземпляр.

Чому потрібно уникати дублювання контенту?

Ось ми, з вами і підійшли до поширеної проблеми, як початківців, так і вже досвідчених веб-майстрів, яка заважає хорошому просуванню сайтів. Це дублювання контенту. Як я вже писала трохи вище, що пошукові системи не люблять ні часткові, а тим більше повні дублікати сторінок. І зовсім не важливо, дублікат чи це з іншого сайту або ж вашої сторінки. Дубль є дубль. Дублі в будь-якому вигляді, для пошукових систем тягнуть за собою вимушене введення резервів, додаткових комп'ютерних потужностей, для індексації і зберігання цих дублів. А це зайві витрати, які нікому не потрібні. У свою чергу пошуковики, всіляко ведуть боротьбу з причинами, які можуть викликати, непотрібні додаткові витрати. Тобто - з дублікатами.

Тому, унікальність статті повинна бути для вас першочерговим завданням. У вас не повинно бути не часткового, неповного дубліката контенту.

Друге для того, щоб успішно просунути сайт, вам потрібен унікальний контент.

Четверте - це звичайно крім унікальності і оптимізації пишіть для людей. Ви повинні писати хороші статті для свого відвідувача. Тим самим покращуючи призначений для користувача фактор.

П'яте - це уникайте дублювання контенту, для того, щоб сайт можна було просувати без проблем.

Какрешіть проблему дублювання контенту?

Для того щоб вирішити проблему дублювання потрібно створити заборони для пошукових систем в файлі robots.txt. З огляду на ці заборони, пошукачі не будуть індексувати дублі контенту. Тим самим ми перед пошуковими системами збережемо обличчя сайту без дублів і знизимо створювану роботами всіх пошукових систем навантаження на сервер. Так само потрібно заборонити до індексації всі службові файли використовуваної вами системи управління контентом (CMS).

Для заборони індексації, доцільно використовувати саме правильний файл robots.txt.

Disallow: /wp-login.php

Disallow: /wp-register.php

Disallow: /xmlrpc.php

Disallow: /template.html

Disallow: / wp-admin

Disallow: / wp-includes

Disallow: / wp-content

В принципі, вибирати Вам, що краще закривати, але на прикладі покажу закриття популярних розділів:

Disallow: / tag

Але, якщо ви плануєте просувати в пошукових системах сторінки тегів, то закривати їх від індексації не потрібно.

Disallow: / category

Disallow: / archive

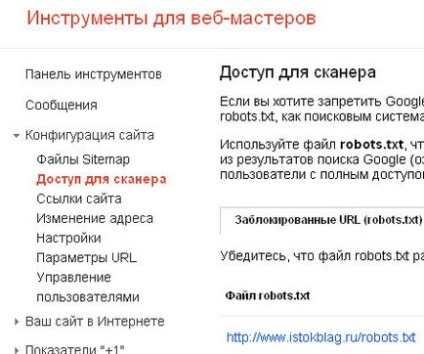

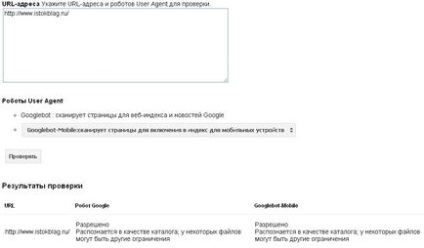

Перевірити правильну роботу файлу robots.txt можна через панель інструментів для веб-майстрів від Google, або через Яндекс Вебмайстер.

Не лінуйтеся перевіряти індексацію. бо це дійсно корисно і потрібно робити. Так як правильна робота файлу robots.txt - це прямий шлях до пошукового трафіку.

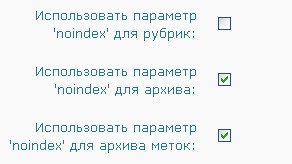

Якщо Ви використовуєте WordPress в якості CMS, то ви можете скористатися багатофункціональним плагіном All in One SEO Pack. Який суттєво допомагає в просуванні сайту, дозволяє заборонити до індексації сторінки з неповними дублями, і допомагає вирішити цілий ряд питань щодо правильної індексації сторінок блогу пошуковими системами.

А також для того щоб уникнути дублювання контенту на WordPress, у вікні налаштувань плагіна All in One SEO Pack поставте галочку в поле «Canonical URLs».

Крім того, обов'язково подбайте про унікальність заголовка і про правильне вигляді сторінки TITLE. Так як пошукові системи надають вмісту TITLE дуже велике значення, і це дійсно дуже важливо.

Для вирішення проблеми дублювання контенту. також, можна вставити тег "Далі". Це тег буде виводити на головну сторінку блогу тільки анонси матеріалів, а інша частина статті буде, відкриваються по посиланню «Читати далі».

Успішного Вам просування сайту!

Щиро Ваша Наталі Бутенко!